(资料图片仅供参考)

(资料图片仅供参考)

“现在的AI技术太强大了,尤其是视频换脸,简直难以分辨真假。”6月5日,家住睢阳区的刘先生说,近来他在网上看到多个AI换脸的小视频,感到真假难辨。“如果不是把知名老年人的面部换到了儿童的身上,简直就能以假乱真了。”

刘先生说,此外,他还听说已经出现了通过AI换脸来进行电信诈骗,对此也存在担忧。

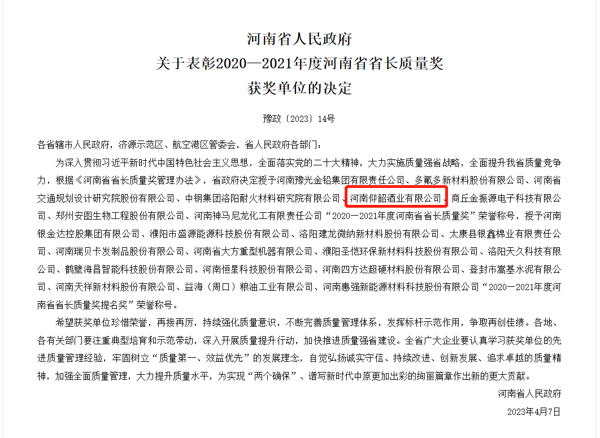

从ChatGPT火爆全网到“AI换脸”新骗局频发,生成式人工智能再次受到广泛关注。据“平安包头”微信公众号消息,内蒙古自治区包头市公安局电信网络犯罪侦查局近期发布一起使用智能AI技术进行电信诈骗的案件,福州市某科技公司法人代表郭先生10分钟内被骗430万元。

“张嘴、摇头,摄像头捕捉到人体动作后,屏幕上原本静态的人像就可以动起来,动作幅度和真人一致,还能眨眼和露齿微笑,仿真度颇高,几分钟内就能生成一段视频,脸还能被任意替换。这就是AI换脸技术,成为不法分子的新型诈骗工具。”市公安局新城派出所民警李莎莎说,AI换脸技术采用的是深度合成技术,利用深度学习、虚拟现实等生成合成类算法,制作图像、音频、视频等信息,目前在社交、影视、广告、医疗等诸多领域不断被深化应用,有较大的技术价值和商用潜力,但也存在一定的安全隐患,“除了AI换脸诈骗之外,还有利用AI进行声音合成实施的诈骗。随着AI技术的广泛使用,AI诈骗逐渐出现在大众视野中,这种诈骗手段对于公众来说极具迷惑性,特别对于那些缺乏足够辨识力的老年人来说,更容易上当受骗。”

李莎莎提醒,为了防范AI换脸诈骗,应该注意保护自己的以下信息或隐私:保护好自己的人脸、指纹、声音等个人生物信息;个人微信、QQ、微博、抖音等社交账号的密码、验证码;不要随便点击陌生的链接、下载陌生的软件或添加陌生的好友。

“AI换脸或者AI声音合成,目前并不能真正做到以假乱真。”李莎莎说,目前AI技术并不能做到完美模拟他人的面部表情及语音,很多诈骗分子担心时间长穿帮,会在实施诈骗时编造一个紧急借口致使受害人一时难以反应,接到这种电话或语音一定要保持冷静,注意分辨,尤其是遇到突如其来的借钱等情况,一定要谨慎对待,并通过多种途径进行核实。

李莎莎提示,如果怀疑对方可能是通过AI伪造的声音,可以尝试用方言与对方交流,或者提问一些只有自己与对方之间才知道的私密信息,核实对方身份,避免被诱骗。当前信息技术发展快,老人常常难以适应,中青年人要及时做好家中老人的宣传教育工作,提醒老年人对不认识、不熟悉的人和事均不要理睬,向老年人及时解析新型诈骗手段,以防被骗。

“一旦涉及到转账汇款时,要多方确认对方身份,通过电话、视频等方式确认对方是否为本人,在不能确定真实身份时,要格外留意、不要着急汇款,避免上当受骗。”李莎莎提醒,也可将转账到账时间设定为“24小时到账”,以预留处理时间。针对支付软件以及网银软件,要使用多种登录及转账验证方式。如果发现上当受骗,应及时向公安机关报警求助。来 源:商丘日报采 写:记者 鲁超编 辑:张书豪审 核:李瑾瑜 杨 宁监 制:张富义总监制:郭文剑 宋圣英微信广告业务合作:13598381996 微信:sqxiaoqiu关键词: